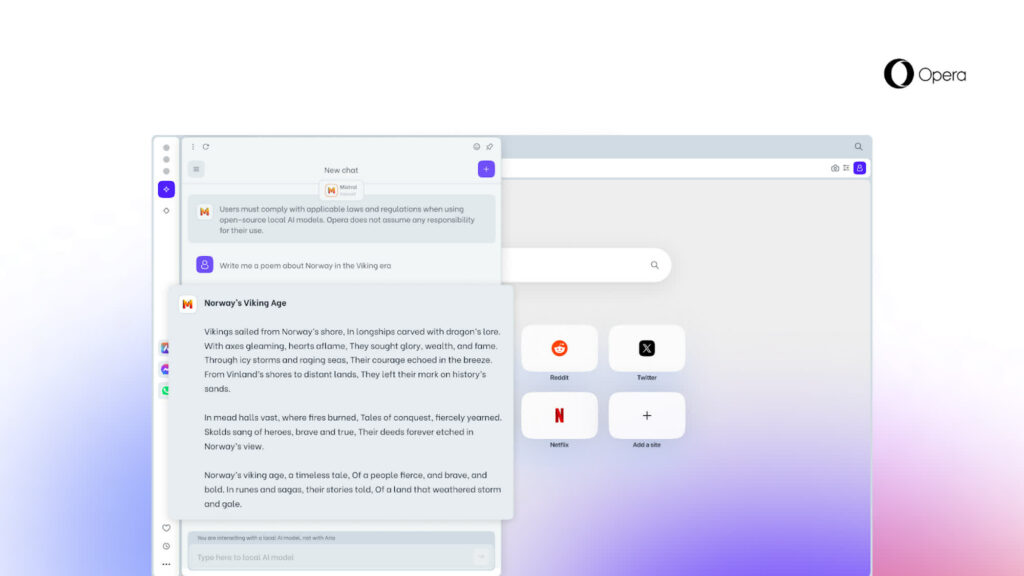

İnternet tarayıcıları arasında bir yenilik rüzgarı esiyor. Opera, kullanıcıların bilgisayarlarında yerel olarak çalışan büyük dil modellerine (LLM) erişim sağlayan ilk tarayıcı oldu. Bu özellik, kullanıcıların verilerini sunuculara göndermeden yapay zeka algoritmalarını kullanmalarına olanak tanıyor. Opera’nın geliştirici sürümüne eklenen bu yeni güncelleme, kullanıcıların kişisel bilgisayarlarında güçlü LLM’leri indirip çalıştırmalarını mümkün kılıyor.

Yerel LLM’ler, verilerin dış “AI sunucularına” gönderilmesini gerektirmeyen bir ortamda çalışır ve Opera’ya göre kullanıcıların gizliliğini korumak için tasarlanmıştır. Opera One Geliştirici, yerel LLM’leri destekleyen ilk tarayıcıdır. Şirketin AI Özellik Damlaları programının bir parçası olarak, Opera tarayıcısı yaklaşık 50 farklı AI model ailesine ait 150 LLM algoritmasına (yerel varyantlarıyla) deneysel destek ekliyor. LLM’ler, tanıdık tarayıcı arayüzü aracılığıyla kolayca erişilebilir ve yönetilebilir hale geliyor ve aralarında Llama (Meta), Vicuna, Gemma (Google), Mixtral (Mistral AI) gibi AI dünyasında tanınan isimler bulunuyor.

Opera, dil modellerinin yerel bir ortamda sınırlı kalması durumunda, verilerin bir kullanıcının cihazında kalacağını ve uzak bir sunucuya herhangi bir bilgi gönderme ihtiyacı olmadığını vurguluyor. AI Özellik Damlaları programı, Chromium tabanlı tarayıcının meraklılarının Opera’nın geliştirdiği yeni özelliklerin erken sürümlerini test etmelerini sağlıyor. Şirket, yerel LLM seçeneğinin “kan sınırlarını zorlayacak kadar yeni” olduğunu ve hatta “bozulabileceğini” söylüyor. Yine de, deney yapmak eğlencelidir, ancak yerel bir LLM çalıştırmak, depolama alanı açısından bazı önemli taahhütler gerektirir. AI sohbet botları için dil modelleri, genellikle çok büyük veri bloklarıdır ve Opera bu gereksinimler konusunda uyarıda bulunur. Her bir LLM, 2 ile 10 gigabayt arasında yerel depolama alanı kaplayacak, Megadolphin gibi öne çıkan bir teklif ise 67GB’lık devasa bir indirme gerektirecektir. Yerel LLM’ler, uzaktan hizmetlere kıyasla “önemli ölçüde daha yavaş” olabilir çünkü bir AI sunucu altyapısından yararlanamazlar. Performans, kullanıcının donanım hesaplama yeteneklerine bağlı olacaktır.

Şirket, Opera One Geliştirici deneysel tarayıcısı aracılığıyla keşfedilebilecek bazı ilginç LLM’ler hakkında tavsiyelerde bulunuyor. Örneğin, Code Llama, Llama’nın bir uzantısı olarak Python, C++, Java ve daha fazlasında kod parçacıkları üretmek ve tartışmak için tasarlanmıştır. Phi-2, “olağanüstü” akıl yürütme ve dil anlama yeteneklerine sahip bir Microsoft Araştırma LLM’si iken, Mixtral doğal dil işleme görevlerinde başarılıdır.